作者:深耕行业的 SmartX 金融团队

内容导读

基于 SMTX OS 5.0 对 NVMe 闪存的优化,SmartX 帮助某基金公司数据中心业务系统进行性能提升验证测试。验证结果表明,相比于生产环境,测试环境下 CISP 估值数据落地单任务跑批时间缩短 85%,多任务跑批时间缩短 82%。

背景简介

在 2015 至 2016 年期间,客户通过 4 台 HP DL580 服务器 + EMC VNX 5600 混闪存储组成的 SAN 架构支撑着两套 Oracle RAC 集群,每套 RAC 上部署多套数据库为业务提供服务。随着硬件设备老化,单台设备故障会对业务造成较大范围的影响。同时,存储资源使用率不断攀升,长期处于高“水位”运行,存储扩容昂贵,维护繁琐,这些因素叠加,为运维带来了较大的压力。

在 2018 年初,客户先后在周边生产和信息化等业务场景中尝试使用了 SmartX 超融合架构。截至当前,两个业务场景中的集群已经稳定运行了超过 4 年时间。在此期间,客户也将一套以 RAC 架构部署的业务系统跑在超融合上进行长时间运行验证,超融合架构的可靠性、稳定性、资源扩展弹性以及监控运维管理的便利性等诸多特性得到了客户的认可。

在 2020 年底,基于现有 2 套超融合集群的稳定表现,客户决定新建一套超融合集群,将传统 SAN 架构上的 2 套 RAC 系统迁移上来,同时对 RAC 进行拆分,由原来的 2 套 RAC 拆分成多套,从而控制硬件设备故障对业务系统造成的影响范围,缓解设备老化和存储资源长期高“水位”运行带来的风险和压力,简化运维。

在 SmartX 超融合架构承载运行多套 RAC 数据库期间,客户关注到基金数据中心业务系统性能较迁移前存在一定的性能提升,与此同时客户也在规划 O32 和 TA 等核心业务系统的未来基础架构平台。看到基金数据中心业务性能提升后,客户想了解,超融合架构是否可以进一步提升该场景下的性能,同时也为后续 O32 和 TA 的基础架构选型提供数据参考,为此围绕“基金数据中心系统”展开 POC 性能验证测试及优化工作。

测试业务系统简介

客户数据中心 V4.0 系统是恒生电子股份有限公司为基金、保险、银行、信托等行业提供的专业资产管理解决方案。该系统通过数据采集及处理工具整合多个业务系统的数据形成数据集中,构建数据分析主题,支持公司及各业务部门的数据使用和分析需要,并在此基础上进行市场营销、客户管理、运营支持、报表报告、投研策略等涵盖公司全业务的数据分析、挖掘等应用。

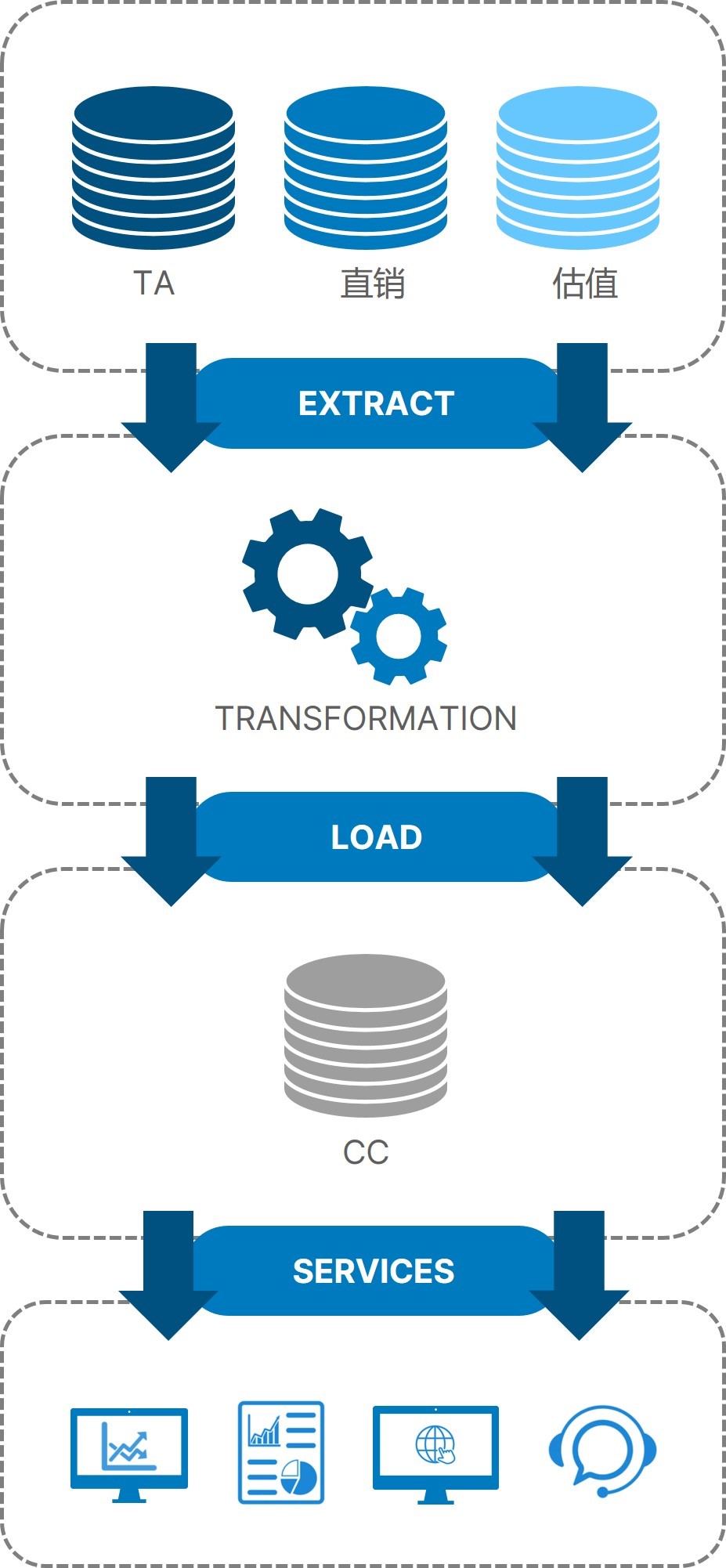

该客户数据中心系统从凌晨开始,每天都会持续进行数据跑批,将直销、估值、TA 等数据库数据抽取出来,经过数据转换,再汇总至数据中心业务系统中,供分析、报表、官网、客服、投资管理等业务部门使用,如图 1 所示。

图 1

图 1

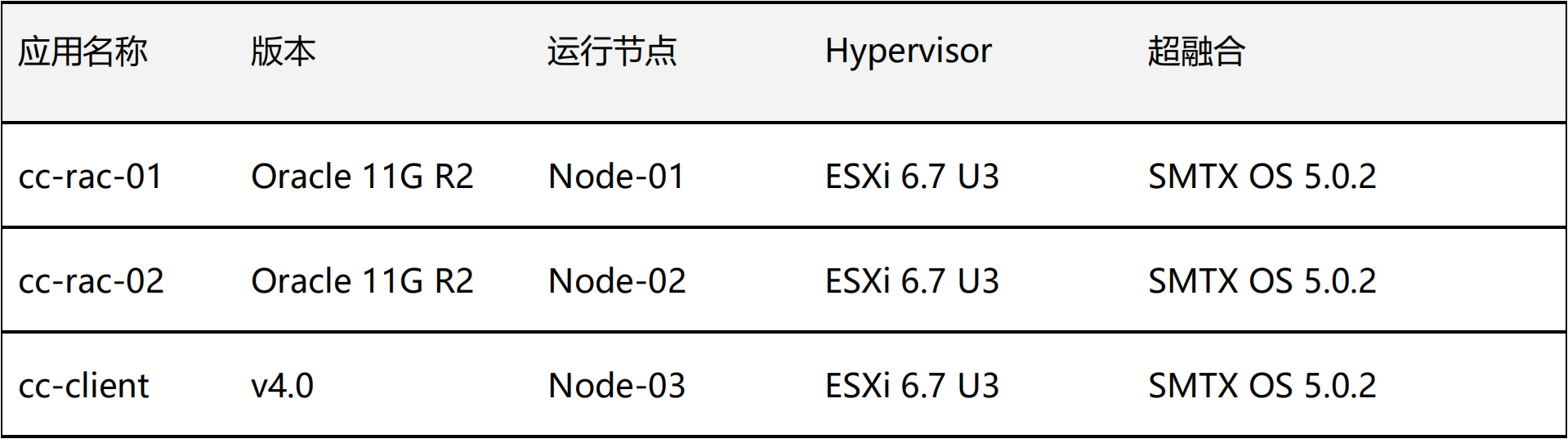

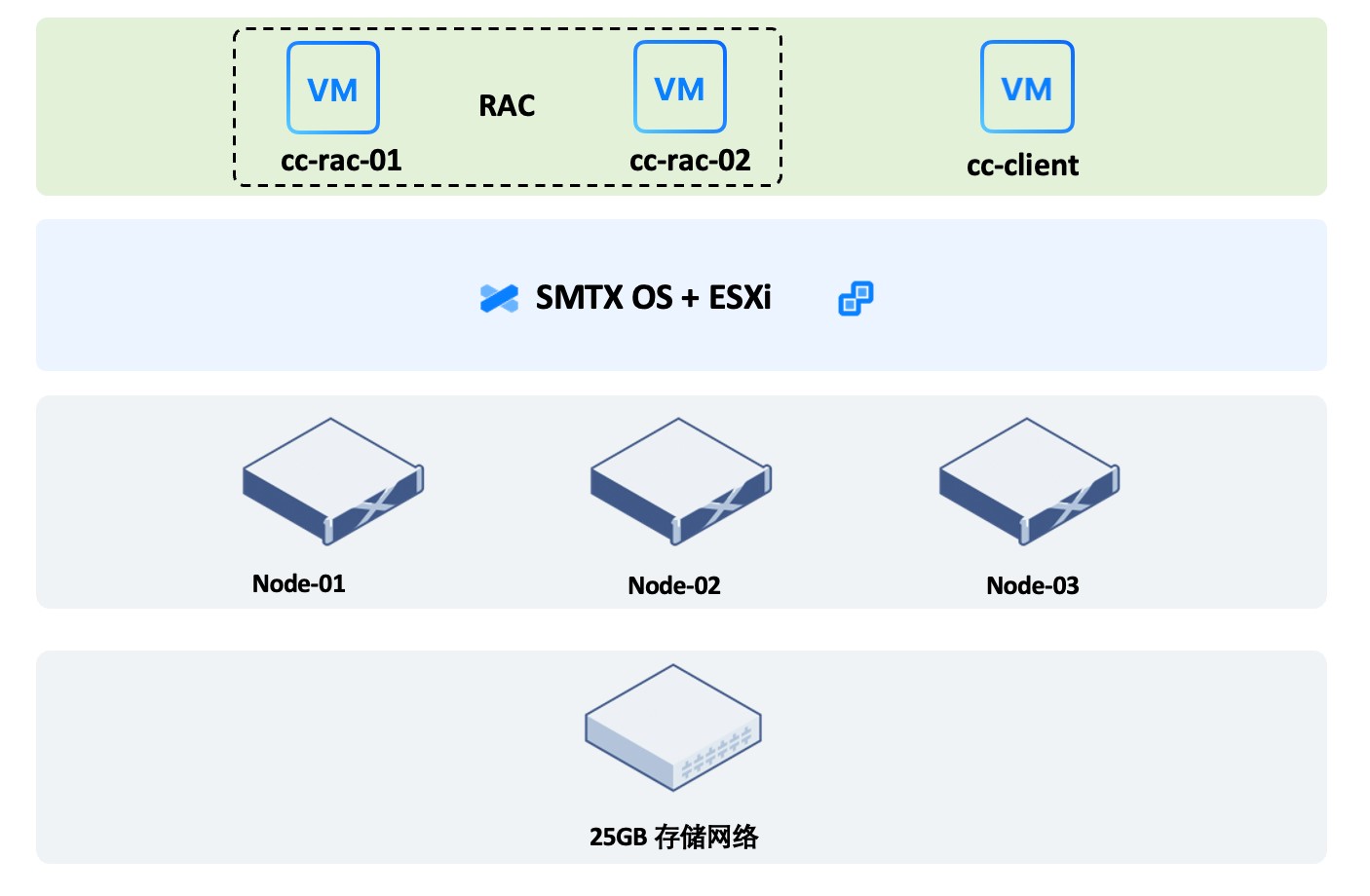

测试应用部署架构

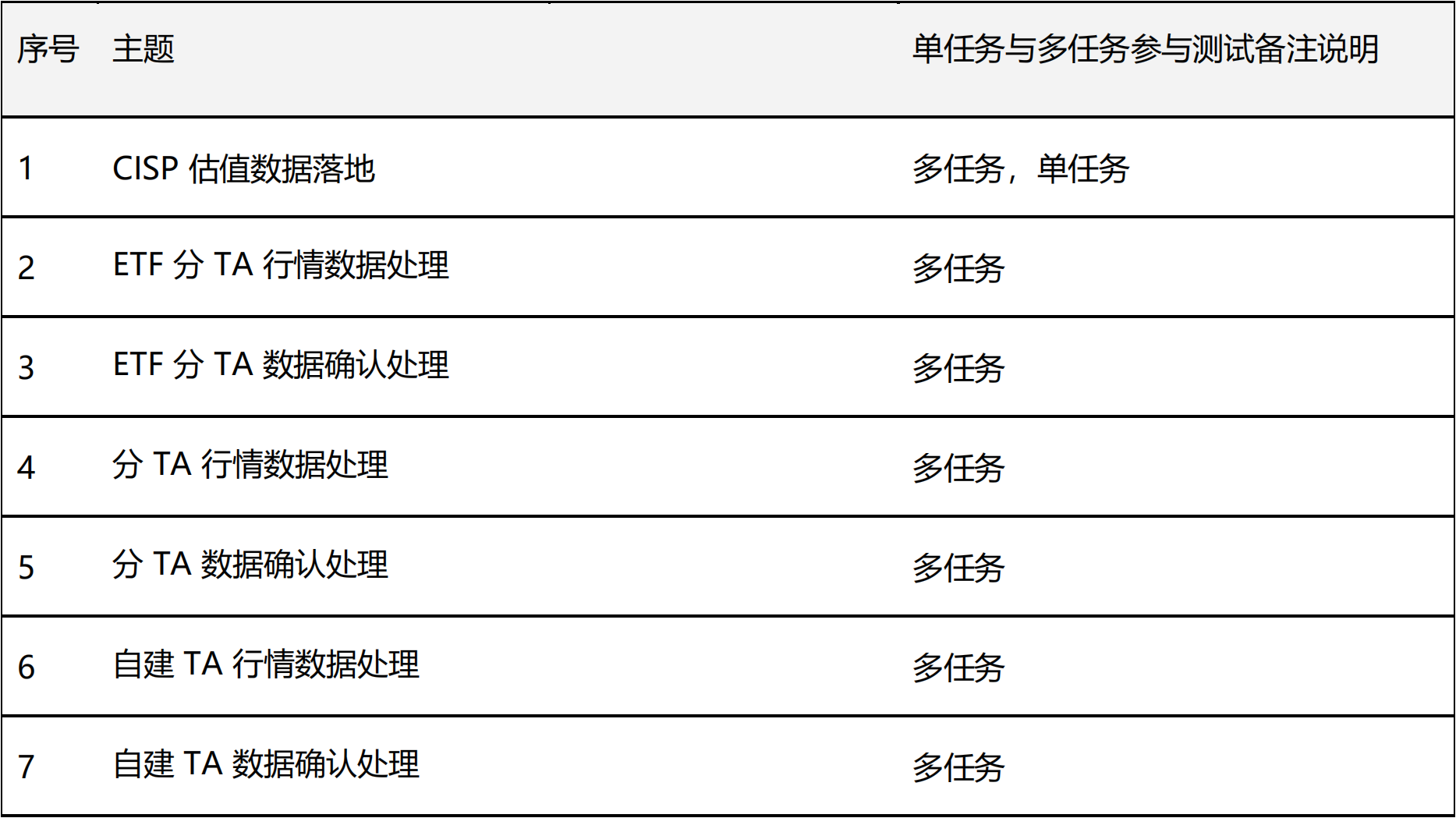

在超融合测试平台,全新部署基金数据中心业务系统(简称 cc ),采用 2 副本存储策略,部署 Oracle RAC 集群 。在测试用例下,进行多种跑批任务模型的组合。本次规划性能测试任务如下:

软硬件设备

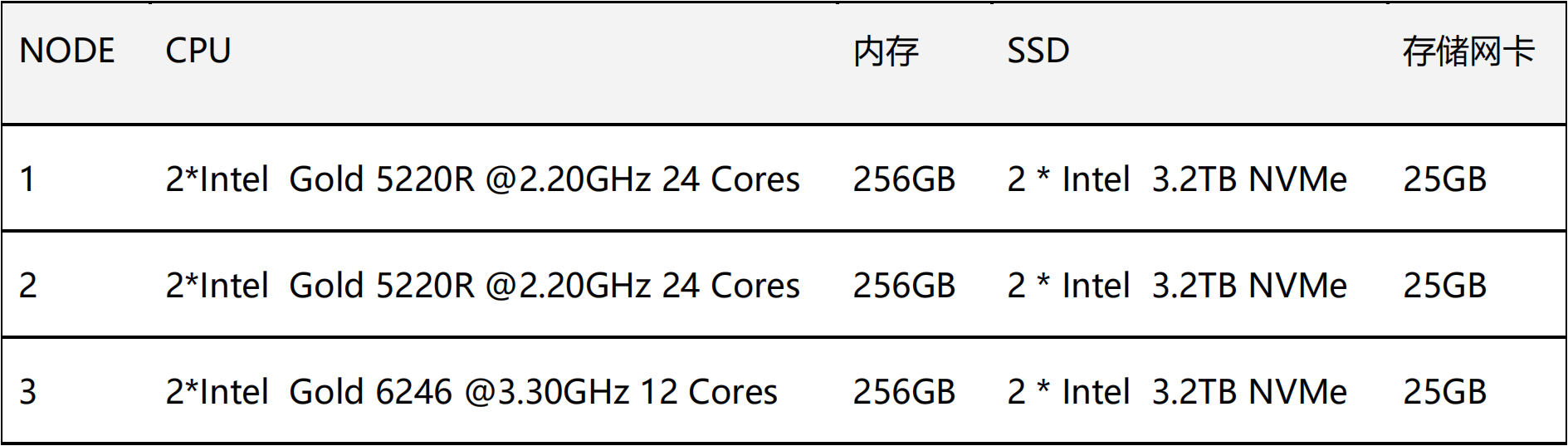

测试硬件配置

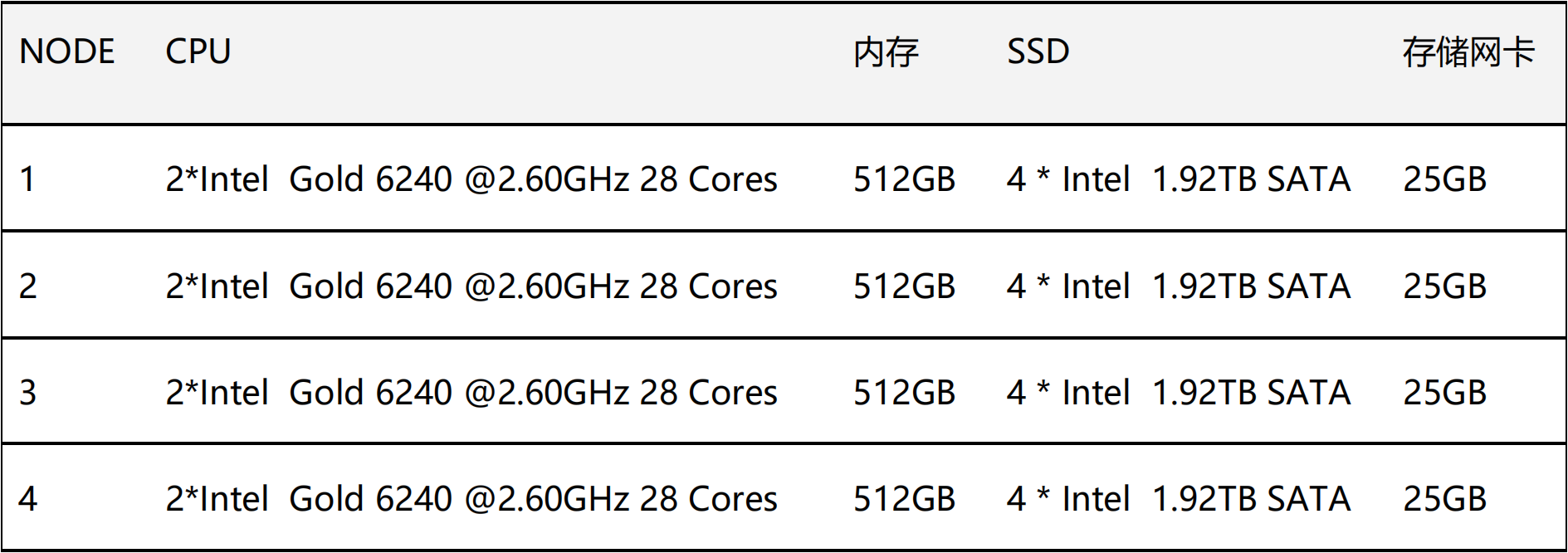

生产硬件配置

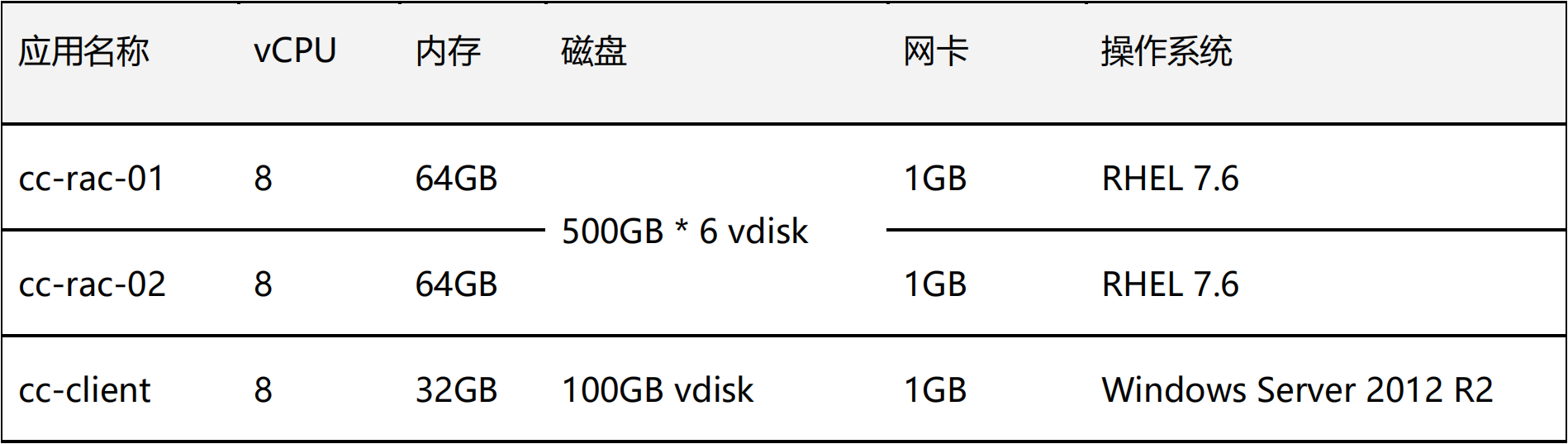

测试软件配置

应用版本

表格 5(注:应用测试版本与生产保持一致,超融合软件测试版本高于生产环境版本的 4.0.10)

表格 5(注:应用测试版本与生产保持一致,超融合软件测试版本高于生产环境版本的 4.0.10)

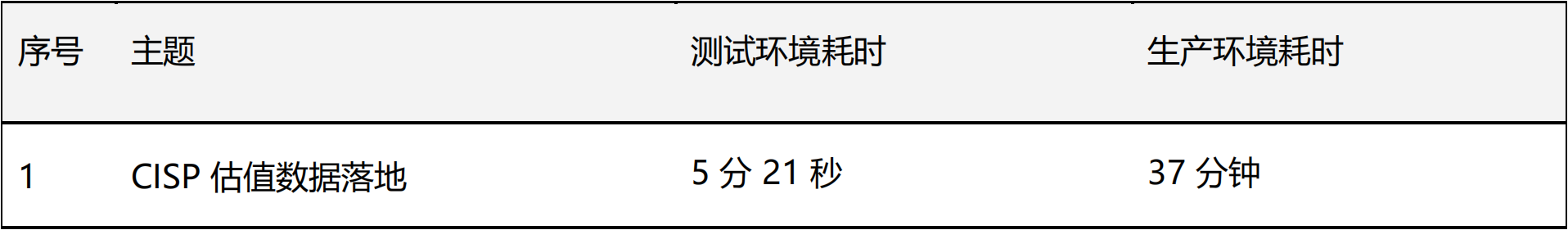

单任务跑批测试结果

针对生产环境中耗时相对较长的场景(CISP 估值数据落地)单独进行了对比测试,通过图 3 跑批结果来看,跑批时间相对于生产环境缩短了 85%,性能优势明显。

单任务场景下主题跑批时间如下表所示:

多任务跑批测试结果

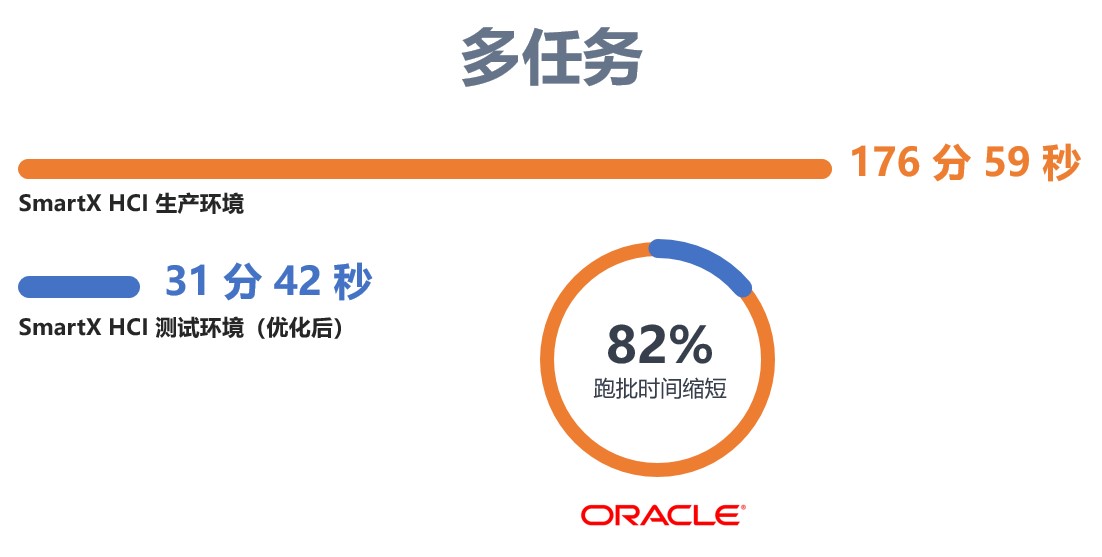

基于单任务跑批的良好测试效果,又引入了部分生产相对耗时较高的跑批任务,跑批结果如图 4 所示,原本近 3 个小时的跑批任务,可以在 30 多分钟完成,跑批时间相比于生产环境缩短了 82%,大幅提升了跑批效率。

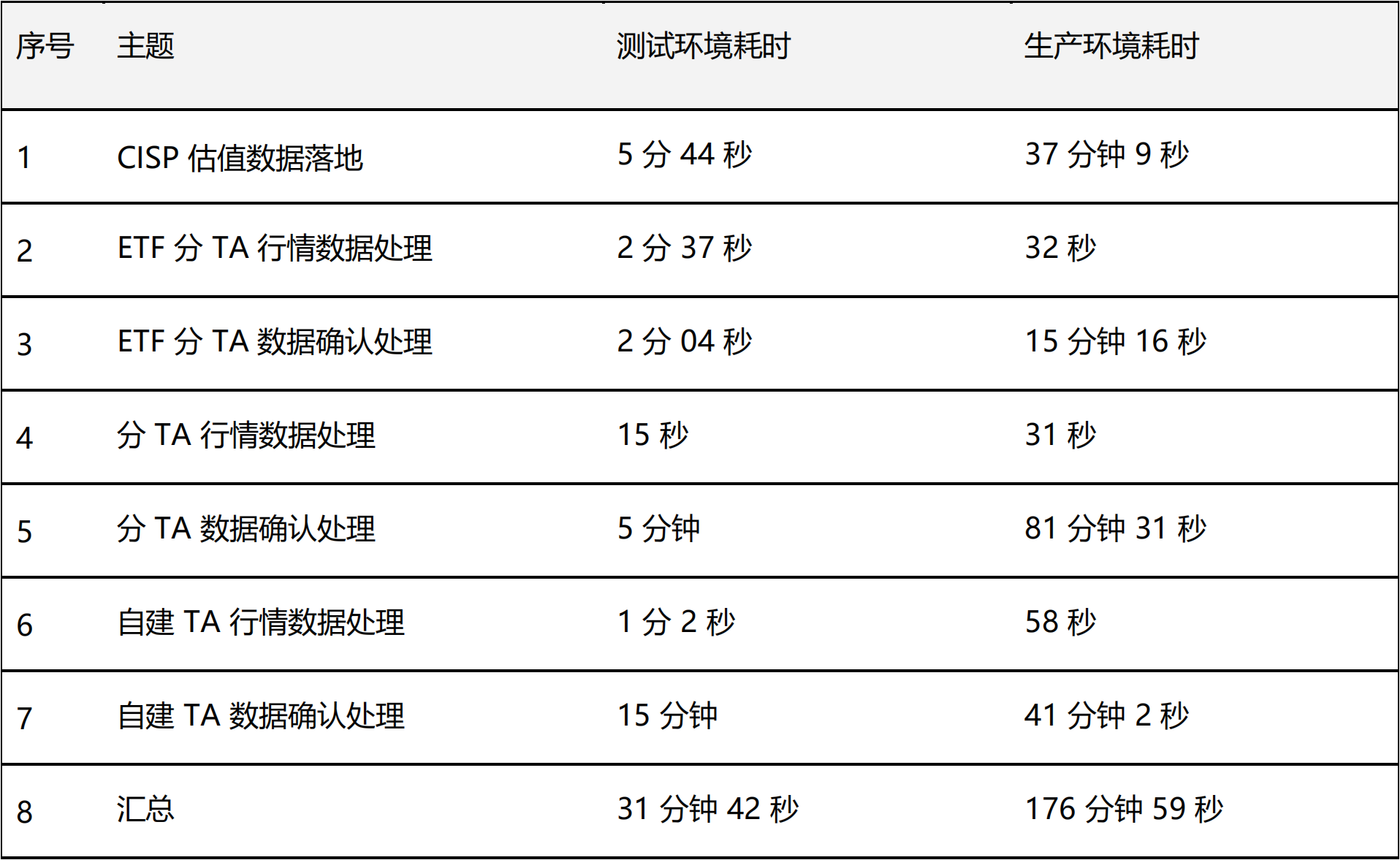

多任务场景下各细分主题跑批时间如下表所示:

跑批期间性能监控

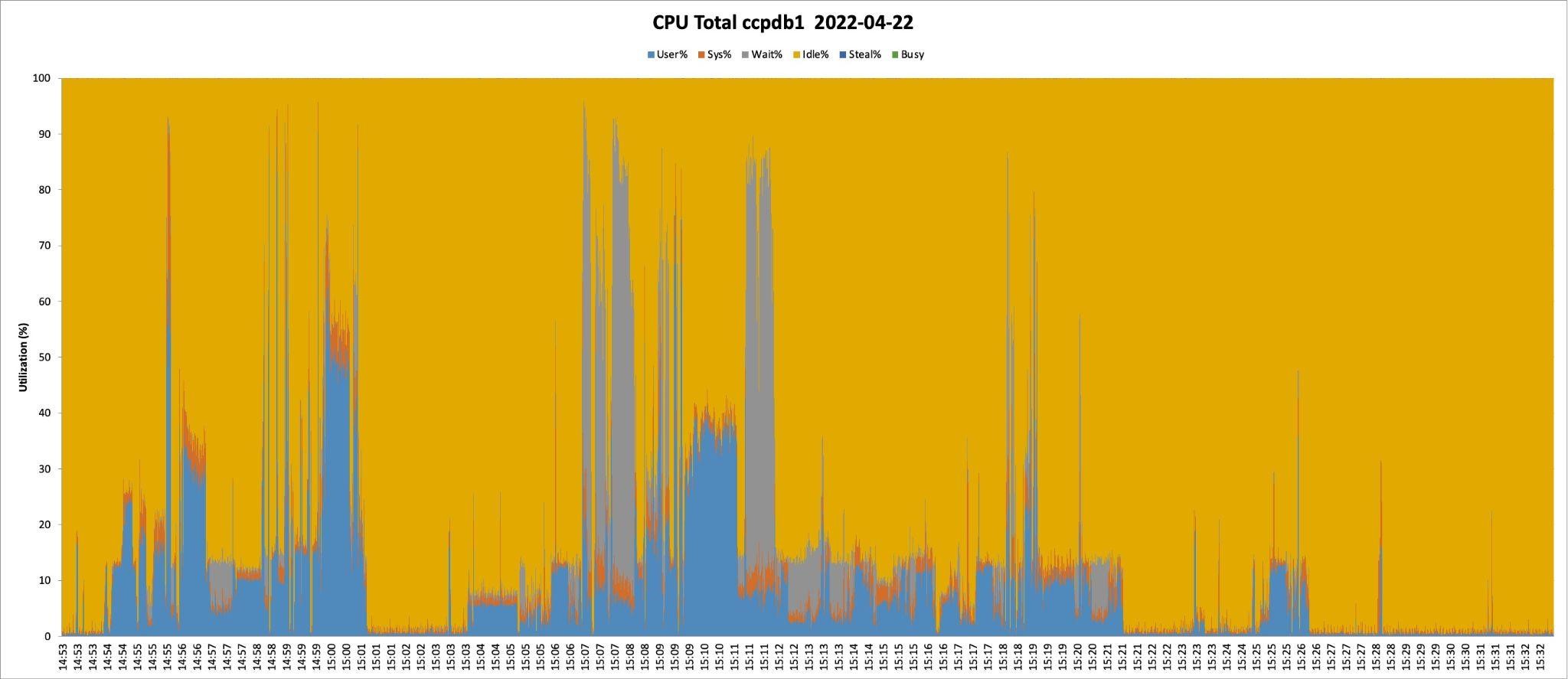

CPU 负载监控数据

CPU User% 在部分时段存在 70%、50%、30% 、20% 等持续时间的连续负载压力,符合跑批场景下的特点。CPU Wait% 部分时段占比较高,通常情况下在 I/O 密集型的应用 Wait% 占比会高一些,对应存储负载的监控也能佐证这一点。

整体看 CPU 具备一定的优化空间,可以考虑为该业务系统分配更多的核心数。

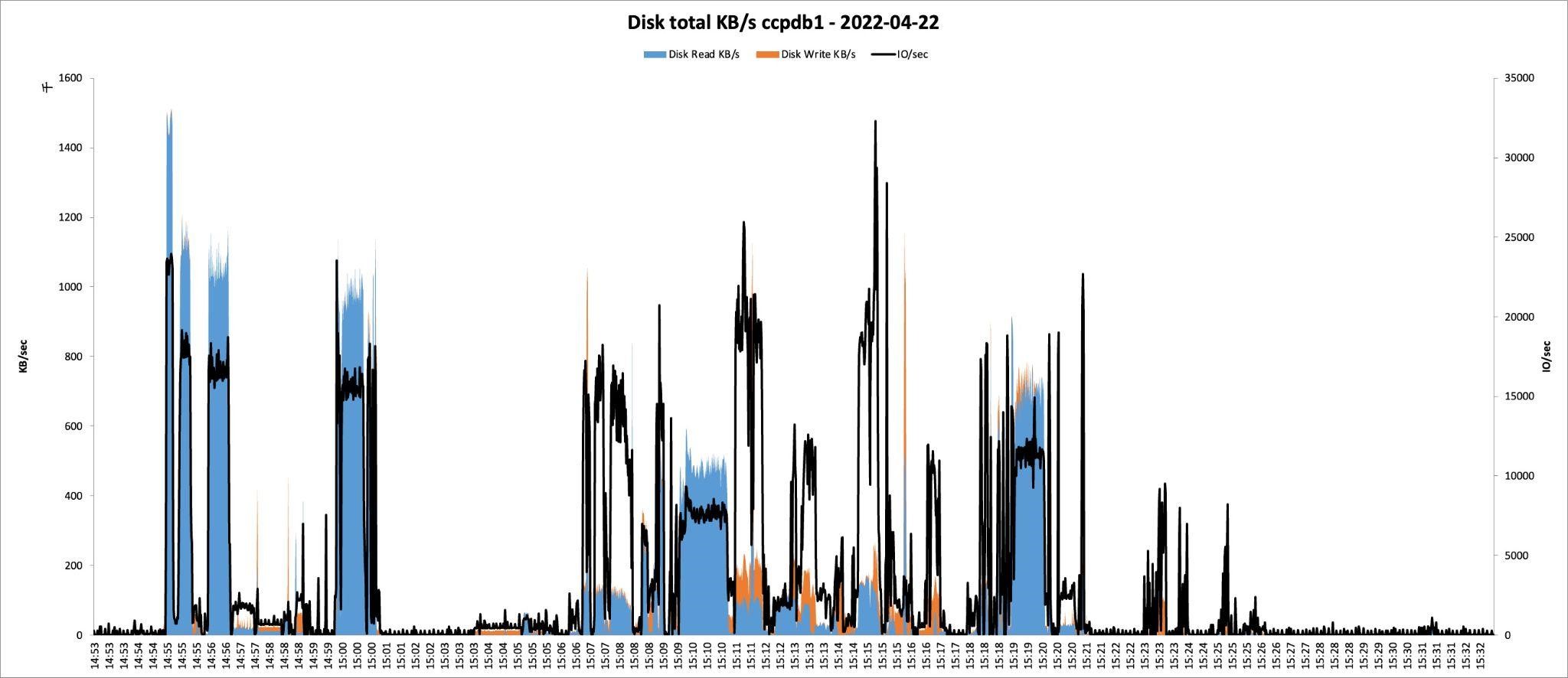

存储负载监控数据

存储以读取压力为主,峰值时存在 1.5GB/s 左右持续读取压力,其余时间存在多次较高的突发访问量,结合 CPU User% 和 Wait% 的占比来看,存储性能是该场景下决定跑批时间的关键因素。

测试总结

基于测试过程和结果,得出以下几点结论:

- 得益于 SMTX OS 5.0 对 NVMe 闪存的优化,结合 25GbE 高速网络,以及 I/O 本地化等特性,存储读写性能得到优化,测试结果相比于生产环境有明显的性能提升。

- 该业务场景的测试结果为后续 TA、O32 等核心业务系统迁移到超融合提供了参考数据。

- 测试期间超融合存储空间使用率达 96%,多次测试的结果之间性能差异仅为秒级, SmartX 超融合架构在高负载场景下依然保持着可靠稳定的性能输出。

展望

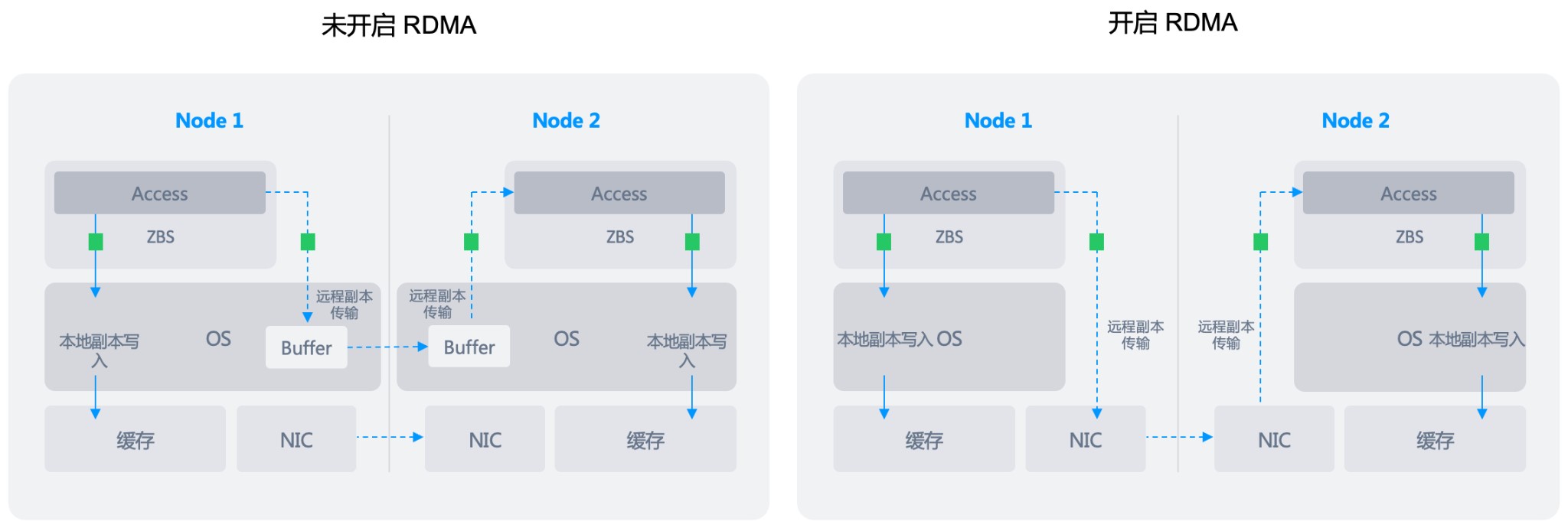

SmartX 对高速硬件的支持得益于超融合与 RDMA (Remote Direct Memory Access)技术的结合。这一技术结合实现了不同节点之间分布式块存储软件 ZBS 的直接通讯,通过网络直接访问其内存数据,副本可以在多个节点间绕过对方的操作系统内核进行传输,由于 bypass 操作系统内核态,可以节省大量 CPU 上下文切换,提高系统吞吐量,降低通信延迟。同时,在 25 GbE、100 GbE、200 GbE 等高速网络条件下可以充分发挥其高带宽优势,同时因为减少了操作系统的缓冲区开销,也有效降低了副本在多个节点间的传输延时。

超融合与 RDMA 技术的结合可以进一步发挥超融合分布式架构的优势,在各种场景下提升业务性能。金融团队后续会陆续推出基于 RDMA 等特性在超融合平台上的场景验证文章。

点击下载 SmartX 金融核心生产业务场景探索文章合集。

图 2

图 2 表格 1

表格 1 表格 2

表格 2 表格 3

表格 3 表格 4(注:测试软件配置与生产保持一致)

表格 4(注:测试软件配置与生产保持一致) 图 3

图 3 表格 6

表格 6 图 4

图 4 表格 7

表格 7 图 5

图 5 图 6

图 6 图 7

图 7